OpenClaw問題の核心:脆弱性と設計不備は分けて考えよ

まず前提として ― OpenClawツールには脆弱性があった

OpenClawを巡る議論では、まず重要な事実があります。

ツールそのものに技術的脆弱性が存在したことです。

ここは曖昧にしてはいけません。

実装レベルの不備や安全設計の甘さがあれば、それは明確にツールの責任です。セキュリティ設計や境界条件処理が不十分であれば、批判は妥当です。

しかし同時に、もう一つ整理しなければならない点があります。

それは、その問題が「AIモデルの欠陥」なのか、「AIを活用するためのツール実装の問題」なのかという切り分けです。

この二つは、技術的にも責任構造的にも、全く別物です。

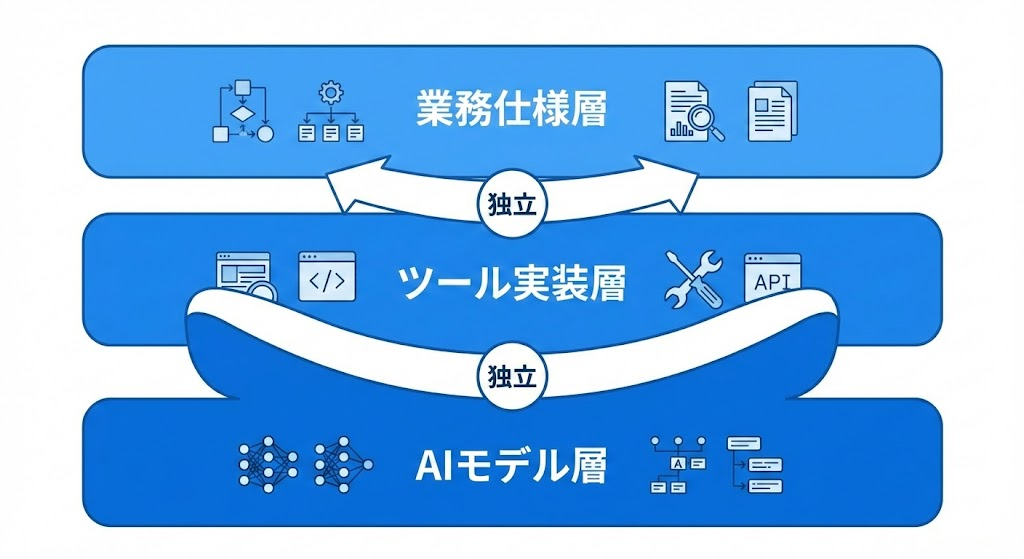

AIモデルとツールは別レイヤーである

生成AIモデルは、入力に対して確率的に出力を生成するエンジンです。

一方、OpenClawのようなツールは、そのモデルを実際の業務やプロダクトに組み込むためのアプリケーション層です。

モデル層

アプリケーション層

業務仕様層

この三層は明確に分離されるべきです。

ツールに脆弱性があることと、AIそのものが危険であることは同義ではありません。

議論が混線すると、本質を見誤ります。

それでも炎上が拡大する理由

ではなぜ、ツールの問題がここまで大きな炎上へ発展するのでしょうか。

理由は単純です。

AIは「未設計」を増幅するからです。

従来の開発では、曖昧な業務仕様や暗黙知は、人間のエンジニアが吸収していました。例外処理も、暗黙の前提も、現場判断で補正されていたのです。

しかしAI仕様駆動では、その吸収層が存在しません。

未定義の状態遷移。

曖昧な権限制御。

例外条件の抜け漏れ。

これらはそのまま挙動として表出します。

ツールに脆弱性があれば、それは露呈します。

仕様が未整理であれば、それもまた露呈します。

AIは加速装置です。良い設計も悪い設計も、拡大します。

仕様書は「責任の設計図」である

ここで強調したいのは、仕様書の意味です。

仕様書は単なるドキュメントではありません。

それは責任の境界線を引く設計図です。

どこまでがツールの責任か。

どこからが業務側の責任か。

どの状態を許容し、どの状態をエラーとするか。

これが明示されていなければ、炎上時に必ず混乱が生じます。

特にAI活用プロジェクトでは、次の三点が不可欠です。

状態遷移の明示。

例外系の事前定義。

制約条件の数値化。

「適切に処理する」という記述は仕様ではありません。

それは希望です。

AIは希望を実装できません。

定義しか実装できません。

OpenClaw問題が示した教訓

OpenClaw騒動は、単なる一企業の問題ではありません。

それは、AI時代における責任構造の複雑化を象徴しています。

ツールに脆弱性があれば、当然改善すべきです。

しかしそれと同時に、仕様未設計のままAIを組み込む危険性も直視すべきです。

- モデル

- ツール

- 仕様

この三層を分離して議論できる組織だけが、AIを安全に使いこなせます。

CTOの役割は「分解すること」

AI時代のCTOに求められるのは、擁護でも批判でもありません。

分解です。

- 技術問題を層に分ける。

- 責任を構造化する。

- 曖昧さを排除する。

株式会社フィールフロウでは、生成AIコンサルティングおよびAIシステム開発において、実装よりも前の仕様設計フェーズを最重要視しています。

AI導入とは、ツール導入ではありません。

設計能力の導入です。

OpenClaw問題は、私たちに問いを投げかけています。

AIを疑う前に、

ツールを疑う前に、

仕様は設計されているか。

その問いに答えられる企業だけが、AI時代を前に進めます。